El análisis de logs es una herramienta fundamental para entender la relación entre un sitio web y los motores de búsqueda. A través de estos registros, podemos obtener valiosos insights sobre el rastreo e indexación, lo que nos permite optimizar la visibilidad de nuestra web en Google y otros buscadores.

En este artículo, exploraremos cómo aprovechar los datos de los logs para mejorar el SEO, identificar información relevante y tomar decisiones estratégicas basadas en estos análisis.

¿Qué es un log y por qué es importante para el SEO?

Un log es un archivo de registro generado por un servidor web que almacena todas las interacciones con el sitio, tanto de usuarios humanos como de bots de motores de búsqueda. Analizando estos registros, podemos comprender cómo los buscadores rastrean nuestro sitio y detectar oportunidades de mejora en la indexación.

Principales bots de motores de búsqueda

Los registros de logs incluyen interacciones con diversos bots. Algunos de los más importantes son:

- Googlebot (Google)

- Bingbot (Bing)

- YandexBot (Yandex)

- Baiduspider (Baidu)

- DuckDuckBot (DuckDuckGo)

- Slurp (Yahoo)

- AhrefsBot y SemrushBot (herramientas SEO)

Entender cuáles bots rastrean nuestro sitio y con qué frecuencia nos permite ajustar nuestra estrategia SEO en consecuencia.

¿Qué información contienen los archivos de logs?

Cada entrada en un archivo de logs incluye información clave sobre la actividad en el servidor. Un registro típico tiene este formato:

78.524.65.345 – – [24/02/2025:24:14:12 +0100] «GET /contacta-con-nosotros HTTP/1.1» 200 «-» «Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)»

Los elementos más relevantes para el análisis SEO incluyen:

- Tipo de petición: GET (solicitud de una página) o POST (envío de datos al servidor).

- Fecha y hora: Indica el momento exacto de la visita.

- IP de la petición: Puede ayudar a identificar bots falsos.

- Código de estado HTTP: Indica la respuesta del servidor (200, 301, 404, 500, etc.).

- User-agent: Identifica al usuario o bot que hace la solicitud.

- URL solicitada: Muestra qué página ha sido visitada.

- Protocolo seguido: Generalmente HTTP/1.1 o HTTP/2.

Estos datos nos permiten detectar problemas técnicos y optimizar la forma en que los motores de búsqueda interactúan con nuestro sitio.

¿Cómo acceder a los archivos de logs?

Antes de realizar un análisis de logs, es necesario obtener los archivos del servidor. Dependiendo del proveedor de hosting, hay varias formas de obtener los logs.

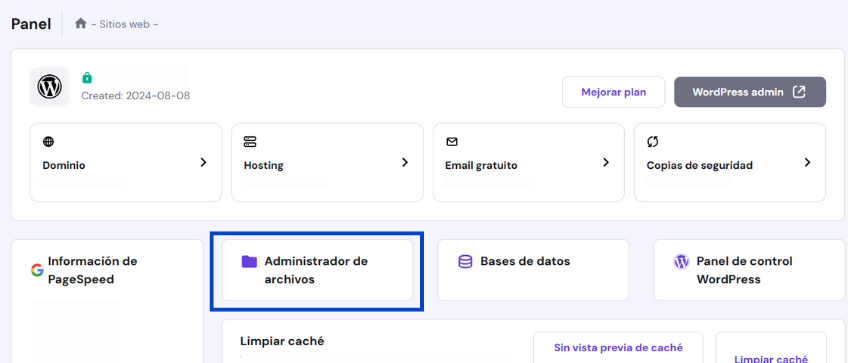

Una de las opciones más comunes es a través del panel de control del hosting (cPanel, HPanel de Hostinger, etc.).

Esta imagen muestra el HPanel de Hostinger, específicamente el Panel de administración del sitio web.

Otra alternativa es acceder directo al servidor mediante terminal (en Apache: /var/log/apache2/access.log, en Nginx: /var/log/nginx/access.log o, con un cliente FTP como FileZilla.

Si el acceso a estos registros está restringido, se puede solicitar directamente al proveedor de alojamiento para obtenerlos.

Claves del análisis de logs en SEO

El análisis de logs ayuda a responder preguntas estratégicas como:

- ¿Qué páginas son rastreadas con mayor frecuencia?

- ¿Google está desperdiciando el Crawl Budget en páginas irrelevantes?

- ¿Existen errores del servidor que afectan la indexación?

A continuación, exploramos en detalle la información clave que aporta este estudio para optimizar un proyecto web en los motores de búsqueda:

Optimización del crawl budget

El presupuesto de rastreo es la cantidad de páginas que Google rastrea en un período determinado. Para optimizarlo:

- Bloquea páginas innecesarias con

robots.txtonoindex. - Mejora la estructura de enlaces internos.

- Evita redirecciones en cadena.

Evaluación de la frecuencia de rastreo

Comprobar con qué frecuencia Google visita cada URL permite priorizar el rastreo de las páginas clave mediante:

- Identificación de páginas huérfanas.

- Mejoras en enlazado interno.

- Actualización de contenido relevante.

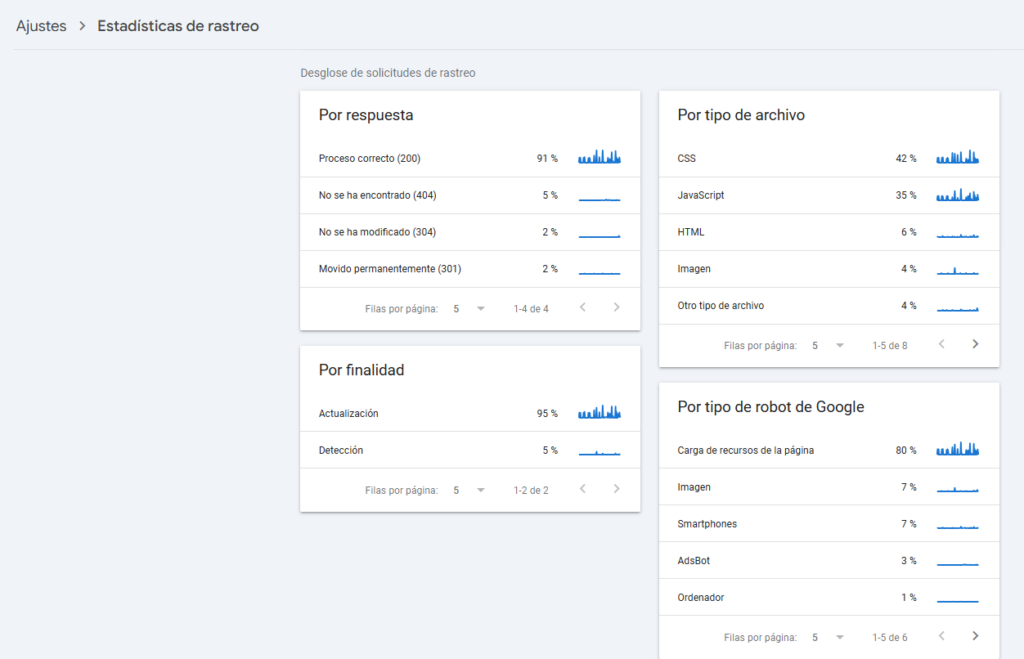

Para visualizar métricas de rastreo en Google Search Console, accedemos a la sección «Ajustes» > «Estadísticas de rastreo». En esta área, encontramos información clave sobre las solicitudes de rastreo de Googlebot, desglosadas por respuesta del servidor, tipo de archivo rastreado y tipo de robot de Google.

Gracias a estos datos, podemos identificar si Google está rastreando correctamente las páginas prioritarias o si está invirtiendo tiempo en archivos menos relevantes, como CSS o JavaScript. Con esta información, podemos tomar decisiones estratégicas para mejorar la eficiencia del rastreo y la indexación del sitio web.

La imagen de Google Search Console muestra las estadísticas de rastreo de un sitio web,

organizadas en diferentes métricas clave que ayudan a entender cómo Googlebot interactúa con las páginas.

Identificación de errores 40X y 50X

Uno de los aspectos más importantes del análisis de logs es detectar errores HTTP que puedan estar afectando la indexación. Los más comunes son:

- 404 (Not Found): Páginas inexistentes, causadas por enlaces rotos.

- 500 (Internal Server Error): Fallos del servidor que impiden la carga de la página.

- 301/302 (Redirecciones): Deben ser revisadas para evitar cadenas innecesarias.

Demasiados errores pueden hacer que Google reduzca la frecuencia de rastreo.

¿Cuándo realizar un análisis de logs?

Como ya hemos visto, el análisis de logs es una herramienta esencial en SEO que se debe aplicar en momentos clave para garantizar que los bots de búsqueda rastreen e indexen las páginas adecuadas. A continuación, detallamos los escenarios más importantes donde su uso es altamente recomendable:

Webs con muchas páginas

Cuando una web tiene una gran cantidad de páginas, el estudio de logs ayuda a controlar aspectos del SEO técnico que de otro modo serían difíciles de verificar. Gracias al análisis de logs, podemos detectar problemas en el rastreo, como errores en los códigos de respuesta HTTP o redirecciones incorrectas que puedan afectar el presupuesto de rastreo.

Problemas de indexación

Si un sitio web presenta problemas de indexación, el análisis de logs permite comprobar si los bots están accediendo a las URLs clave del proyecto. Esto facilita la identificación de patrones de rastreo y ayuda a verificar si Googlebot visita realmente las páginas que queremos indexar.

Migraciones o reesctructuraciones

Las modificaciones en la estructura interna de un sitio web o una migración requieren una monitorización constante para evitar problemas que puedan perjudicar el posicionamiento SEO. Un análisis de logs posterior a estos cambios permite detectar errores 40X y 50X, asegurando que todas las URLs redirijan correctamente a su nuevo destino.

Optimización del crawl budget

El estudio de logs también ayuda a determinar qué URLs reciben más visitas de los bots, lo que indica qué contenido consideran más relevante. Si hay páginas importantes que apenas son rastreadas, se pueden tomar medidas como mejorar el enlazado interno o actualizar su contenido para incentivar su rastreo.

Realizar un análisis de logs de manera periódica, especialmente en estos escenarios, permite optimizar el rastreo y la indexación de un sitio web, garantizando que los motores de búsqueda prioricen las páginas más importantes.

Herramientas recomendadas para el análisis de logs

Existen varias herramientas que facilitan el análisis de logs sin necesidad de procesar manualmente los archivos. Algunas de las más utilizadas en SEO son:

- Screaming Frog Log File Analyzer: Permite analizar archivos de logs y detectar patrones de rastreo.

- Seolyzer: Extrae datos clave del comportamiento de Googlebot en un sitio web.

- SEMrush Log File Analyzer: Ayuda a identificar problemas de indexación y optimizar el Crawl Budget.

- GoAccess: Una herramienta gratuita para visualizar logs en tiempo real.

Cada una de estas herramientas ofrece visualizaciones gráficas y métricas clave que facilitan la interpretación de los datos.

Inteligencia Artificial aplicada al análisis de logs

Además de estas herramientas especializadas, la inteligencia artificial (IA) está revolucionando la forma en que se analizan los logs, permitiendo una interpretación más rápida y detallada de los datos.

- ChatGPT: Puede ayudarte a procesar archivos de logs, identificar patrones de rastreo y sugerir optimizaciones SEO basadas en los datos extraídos. Simplemente cargando el archivo de logs, puedes obtener insights sobre los códigos de estado HTTP, errores recurrentes y el comportamiento de Googlebot.

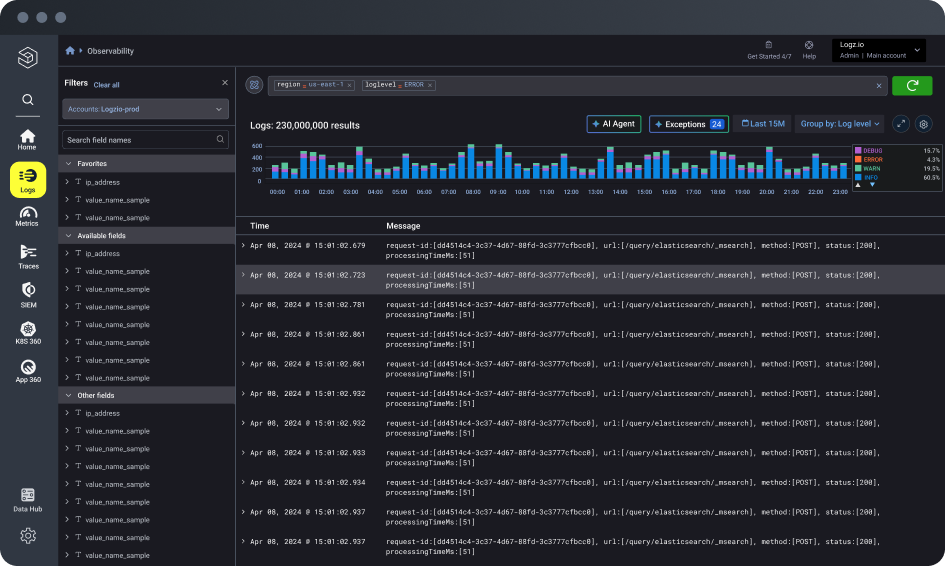

- Logz.io: Plataforma basada en IA que permite monitorear y analizar logs en tiempo real, facilitando la detección de anomalías en el rastreo.

- New Relic AI: Ayuda a interpretar registros del servidor y detectar problemas de rendimiento que pueden afectar la indexación.

- Datadog: Integra IA para correlacionar datos de logs con métricas SEO y ofrecer recomendaciones basadas en el comportamiento del rastreo.

Gracias a estas herramientas, tanto tradicionales como basadas en IA, el análisis de logs se ha vuelto más eficiente, proporcionando información clave para mejorar la indexación y el rendimiento SEO de cualquier sitio web.

Interfaz de Logz.io, una plataforma de observabilidad basada en inteligencia artificial para el análisis y monitoreo de logs en tiempo real.

En conclusión, el análisis de logs es una técnica esencial para entender cómo los motores de búsqueda interactúan con un sitio web. A través de este proceso, podemos:

- Detectar errores de rastreo y solucionarlos rápidamente.

- Optimizar el Crawl Budget, asegurando que Google prioriza las páginas importantes.

- Mejorar la frecuencia de rastreo y la indexación de contenido relevante.

- Prevenir problemas de acceso al sitio que puedan afectar el posicionamiento.

Aunque el análisis de logs puede parecer complejo, su correcta implementación puede transformar significativamente la visibilidad de un sitio web en Google. Si aún no has explorado esta técnica, te sugiero primero familiarizarte con los fundamentos del SEO y luego aplicar ese conocimiento en el estudio de los registros del servidor. Esto te permitirá optimizar el rastreo, mejorar la indexación y fortalecer tu estrategia SEO con decisiones basadas en datos.